AIFaaS

L'usine d'IA en tant que service

Donnez à votre entreprise les outils et les cadres dont elle a besoin pour créer, former et déployer l'IA sur une couche GPU entièrement gérée, sécurisée et multi-tenant.

Entreprise entièrement gérée

Flux de travail de l'IA

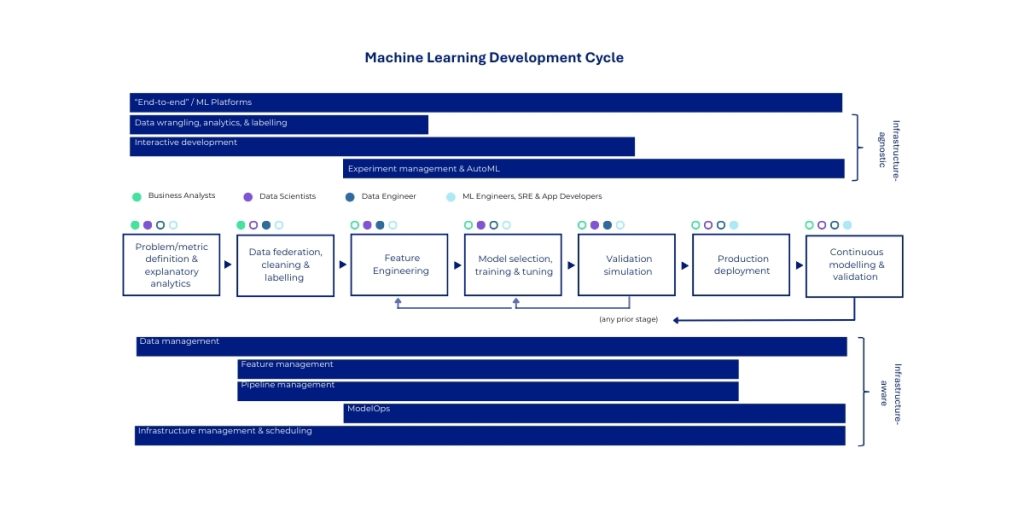

AIFaaS est notre première offre de plateforme à forte valeur ajoutée qui fournit un environnement de bout en bout entièrement géré pour l'ensemble du flux de travail de l'entreprise en matière d'IA. Construit en toute sécurité sur notre couche GPUaaS multi-tenant, ce service est une implémentation commerciale de la suite logicielle complète NVIDIA AI Enterprise, fournie comme un “ atelier ” privé et isolé pour les équipes de science des données et d'ingénierie ML d'une organisation. Il fait abstraction de l'immense complexité de la construction et de la maintenance d'une plateforme d'IA de niveau production, permettant aux équipes de se concentrer sur la création de valeur pour l'entreprise.

Ce service fournit un accès géré à un ensemble complet de frameworks d'IA de NVIDIA, leaders sur le marché. Il s'agit notamment du framework NVIDIA NeMo, qui propose des outils puissants pour les techniques de personnalisation des modèles telles que le réglage fin et la génération améliorée par récupération (RAG), permettant aux clients d'adapter en toute sécurité les modèles de base de pointe avec leurs propres données propriétaires.

NVIDIA NIM

NVIDIA NIM™ propose des solutions conteneurisées pour déployer des microservices d'inférence d'IA accélérés par le GPU. Ces microservices fonctionnent avec des modèles d'IA pré-entraînés et personnalisés, en fournissant des API standard qui s'intègrent de manière transparente dans vos applications, frameworks et flux de travail existants. Chaque microservice encapsule un modèle spécifique (tel qu'un modèle de traduction linguistique ou un modèle de résumé de texte) et est finement ajusté par NVIDIA pour extraire le maximum de performances d'inférence de l'architecture GPU H200. Cette optimisation se traduit par une latence la plus faible possible et un débit le plus élevé possible, ce qui est essentiel pour les applications en temps réel orientées vers l'utilisateur.

Recherche d'entreprise

Déployer des MNI d'intégration pour la recherche sémantique de documents

Soutien à la clientèle

Les MNI du LLM alimentent des chatbots intelligents

Création de contenu

NIM de génération d'images pour les équipes de marketing

Soins de santé

Analyse de l'imagerie médicale avec les MNI de vision

Services financiers

Traitement et analyse des documents

NVIDIA NeMo

NVIDIA NeMo™ est une plateforme d'entreprise conçue pour gérer le cycle de vie complet des agents d'IA grâce à des composants modulaires et interconnectés. NeMo fournit des microservices et des outils pour la curation des données, la personnalisation et l'évaluation des modèles, la mise en œuvre de contrôles de sécurité et la surveillance des performances.

Les microservices NeMo comprennent

- Conservateur NeMo

- Personnalisateur NeMo

- Évaluateur NeMo

- Retriever NeMo

- Garde-corps NeMo

- Boîte à outils de l'agent NeMo

Banque

Un chatbot bancaire utilise les garde-fous NeMo pour empêcher les discussions sur les données d'investissement confidentielles, bloquer les tentatives d'extraction des données des clients et s'assurer que les informations financières fournies comprennent les clauses de non-responsabilité appropriées.

Formation

Une plateforme de formation prend un modèle de base GPT et l'affine sur 50 000 interactions clients historiques pour créer un agent IA qui traite les retours, les réclamations et les questions sur les produits en suivant les politiques de l'entreprise.

SDK d'applications NVIDIA AI

Les SDK NVIDIA AI Applications sont des plateformes de développement de bout en bout, spécifiques à un domaine, qui regroupent l'ensemble de la pile IA (bibliothèques, frameworks, modèles pré-entraînés, outils et flux de travail) dans des boîtes à outils complètes conçues pour des industries et des cas d'utilisation spécifiques.

Considérez-les comme des solutions complètes plutôt que comme des blocs de construction individuels. Alors que les NIM et les microservices sont comme des briques LEGO que l'on assemble, les SDK d'applications ressemblent davantage à des jeux LEGO préconçus avec des instructions pour construire des objets spécifiques (un château, un vaisseau spatial, etc.).

Exemple : NVIDIA Riva est un SDK accéléré par le GPU pour créer et déployer des applications d'IA conversationnelle en temps réel entièrement personnalisables. Ces applications comprennent la reconnaissance automatique de la parole (ASR), la synthèse vocale (TTS) et la traduction automatique neuronale (NMT).

Kubernetes

Pour une orchestration évolutive des charges de travail d'IA sur les clusters GPU, permettant l'allocation de ressources multi-locataires et une mise à l'échelle automatisée.

Outil MLOps et LLMOps

Gestion de pipelines pour l'entraînement, l'ajustement, le déploiement et le suivi des modèles avec l'observabilité, la gouvernance et la conformité intégrées.