AIFaaS

Fábrica de IA como servicio

Proporcione a su empresa las herramientas y los marcos que necesita para crear, entrenar e implantar la IA en una capa de GPU totalmente gestionada, segura y multiusuario.

Empresa totalmente gestionada

Flujo de trabajo AI

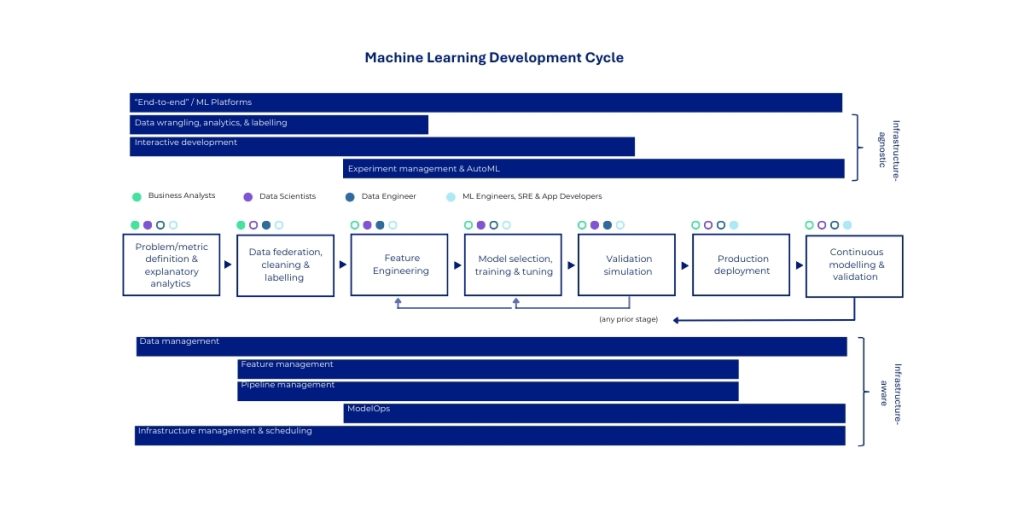

AIFaaS es nuestra principal oferta de plataforma de alto valor que proporciona un entorno integral totalmente gestionado para todo el flujo de trabajo de IA empresarial. Construido de forma segura sobre nuestra capa GPUaaS multi-tenant, este servicio es una implementación comercial de la suite completa de software NVIDIA AI Enterprise, entregada como un “banco de trabajo” privado y aislado para los equipos de ingeniería de ML y ciencia de datos de una organización. Abstrae la inmensa complejidad de crear y mantener una plataforma de IA de nivel de producción, lo que permite a los equipos centrarse en aportar valor al negocio.

El servicio proporciona acceso gestionado a un amplio conjunto de marcos de IA de NVIDIA, líderes en el sector. Esto incluye el marco NVIDIA NeMo, que ofrece potentes herramientas para técnicas de personalización de modelos como el ajuste fino y la generación mejorada por recuperación (RAG), lo que permite a los clientes adaptar de forma segura los modelos básicos más avanzados con sus propios datos.

NVIDIA NIM

NVIDIA NIM™ ofrece soluciones en contenedores para implantar microservicios de inferencia de IA acelerados en la GPU. Estos microservicios funcionan tanto con modelos de IA preentrenados como personalizados y proporcionan API estándar que se integran a la perfección en las aplicaciones, los marcos y los flujos de trabajo existentes. Cada microservicio encapsula un modelo específico (como un modelo de traducción de idiomas o un modelo de resumen de texto) y está ajustado por NVIDIA para extraer el máximo rendimiento de inferencia de la arquitectura de la GPU H200. Esta optimización da como resultado la menor latencia posible y el mayor rendimiento, lo que es fundamental para las aplicaciones de tiempo real dirigidas al usuario.

Búsqueda empresarial

Despliegue de NIM incrustados para la búsqueda semántica de documentos

Atención al cliente

Los NIM de LLM impulsan los chatbots inteligentes

Creación de contenidos

Generación de imágenes NIM para equipos de marketing

Sanidad

Análisis de imágenes médicas con NIM de visión

Servicios financieros

Tratamiento y análisis de documentos

NVIDIA NeMo

NVIDIA NeMo™ es una plataforma de nivel empresarial diseñada para gestionar el ciclo de vida completo de los agentes de IA a través de componentes modulares e interconectados. NeMo ofrece microservicios y herramientas para conservar datos, personalizar y evaluar modelos, implementar controles de seguridad y supervisar el rendimiento.

Los microservicios NeMo incluyen:

- Conservador NeMo

- Personalizador NeMo

- Evaluador NeMo

- NeMo Retriever

- Barandillas NeMo

- Kit de herramientas para agentes NeMo

Banca

Un chatbot bancario utiliza NeMo Guardrails para evitar discusiones sobre datos confidenciales de inversión, bloquear intentos de extraer datos de clientes y garantizar que la información financiera proporcionada incluya los descargos de responsabilidad adecuados.

Formación

Una plataforma de formación toma un modelo base de GPT y lo afina sobre 50.000 interacciones históricas con clientes para crear un agente de IA que gestione devoluciones, reclamaciones y preguntas sobre productos siguiendo las políticas de la empresa.

SDK de aplicaciones de IA de NVIDIA

Los SDK de aplicaciones de IA de NVIDIA son plataformas de desarrollo integrales y específicas de cada dominio que agrupan toda la pila de IA (bibliotecas, marcos de trabajo, modelos preentrenados, herramientas y flujos de trabajo) en completos kits de herramientas diseñados para sectores y casos de uso específicos.

Piense en ellos como paquetes de soluciones completas más que como bloques de construcción individuales. Mientras que NIM y los microservicios son como ladrillos de LEGO que se montan, los SDK de aplicaciones son más bien juegos de LEGO prediseñados con instrucciones para construir cosas específicas (un castillo, una nave espacial, etc.).

Ejemplo: NVIDIA Riva es un SDK acelerado en la GPU para crear e implantar aplicaciones de IA conversacional en tiempo real totalmente personalizables. Incluye reconocimiento automático del habla (ASR), conversión de texto a voz (TTS) y traducción automática neuronal (NMT).

Kubernetes

Para la orquestación escalable de cargas de trabajo de IA en clústeres de GPU, lo que permite la asignación de recursos multiarrendatario y el escalado automatizado.

Herramientas MLOps y LLMOps

Gestión de canales para la formación, el ajuste, la implantación y la supervisión de modelos con capacidad de observación, gobernanza y cumplimiento incorporados.